Ethische KI-Fragen bei autonomen Fahrzeugen – das Trolley-Problem 2.0 im Spiegel von Technik, Recht und Moral

Wenn dein Auto entscheidet,

wer überlebt

Du steigst ein, gibst dein Ziel ein – und lehnst dich zurück. Doch was, wenn dein selbstfahrendes Auto plötzlich schneller entscheidet als du denken kannst – und dabei dein Leben gegen das eines anderen abwägt?

Ein Kind rennt auf die Straße. Rechts ein Betonpfeiler, links eine Gruppe Fußgänger:innen. Keine Zeit zum Bremsen. Wer wird geschont? Wer geopfert?

Was früher reine Theorie war, ist heute hochaktuelle Praxis. Willkommen beim Trolley-Problem 2.0 – real, programmiert und (noch) ungelöst.

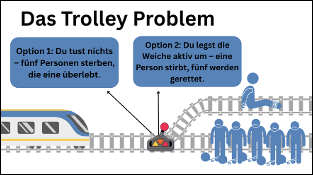

Die Grundkonstellation des Trolley Problems

Ein Trolley rast auf fünf Menschen zu. Du kannst ihn auf ein Nebengleis umleiten – dort liegt aber eine einzelne Person. Lenkst du um und opferst bewusst einen – oder tust du nichts und lässt fünf sterben?

⚖️ Die ethischen Schulen

- Utilitarismus (Bentham, Mill): Das größtmögliche Glück für die größtmögliche Zahl rechtfertigt das Opfer.

- Deontologie (Kant): Einen Menschen als Mittel zum Zweck zu behandeln, ist niemals moralisch.

- Rechtsphilosophie: Soll eine Rechtsordnung solche Abwägungen überhaupt vorsehen? Oder ist das die Grenze des Rechts?

Vom Gleis zur Straße: KI und moralische Algorithmen

Autonome Fahrzeuge stehen täglich vor ähnlichen Entscheidungen. Nur ist die Weiche hier ein Algorithmus. Im Gegensatz zum Menschen entscheidet die Maschine nicht intuitiv, sondern nach vordefinierten Regeln – programmiert von Menschenhand.

Und genau hier beginnt das Problem: Wer definiert diese Regeln? Darf man sie überhaupt festlegen? Und: Ist ein Algorithmus, der Leben gegeneinander „optimiert„, juristisch zulässig?

„Terror“ – wenn Strafrecht auf Maschinenethik trifft

Ferdinand von Schirachs Theaterstück „Terror“ zeigt einen Kampfpiloten, der ein Passagierflugzeug abschießt, um 70.000 Menschen in einem Stadion zu retten. In Publikumsabstimmungen halten ihn 86,9 % für unschuldig. Doch was, wenn nicht mehr ein Mensch entscheidet, sondern eine KI?

Was, wenn der entscheidende Code lautet: „Wenn mehr Leben gerettet werden können, lenke in Richtung des Einzelnen“?

Wäre das dann systematischer Mord?

- Wer trägt die Verantwortung? Die Entwickler:innen? Der Hersteller? Niemand?

- Darf ein Tesla wissen, dass sich fünf Menschen auf der Straße befinden, aber nichts tun, weil moralische Entscheidungen juristisch zu heikel sind?

Tesla etwa trifft bewusst keine moralischen Abwägungen. Denn jede Kodifizierung von Leben-vor-Leben-Entscheidungen könnte strafrechtliche Konsequenzen nach sich ziehen.

Zwischen Gesetz und Gewissen:

3 Strategien für Maschinenmoral

- Explizite Werte einprogrammieren: Die Maschine folgt ethischen Leitlinien (z. B. „Rette möglichst viele“). → Aber: Entwickler:innen könnten strafrechtlich verantwortlich gemacht werden.

- Keine Bewertung erlauben: Das Fahrzeug darf nicht abwägen, sondern nur technisch ausweichen. → Kann zu irrationalen oder tragischen Entscheidungen führen.

- Risiko minimieren, Entscheidung vermeiden: Der Algorithmus vermeidet Dilemmata (vorsichtiges Fahren, breites Sicherheitsabstandsmanagement oder sehr konservative Entscheidungslogiken), trifft aber keine moralischen Urteile. → De-facto-Standard in der Industrie. Wirkt beruhigend, umgeht aber das eigentliche Problem: dass in der Realität moralische Entscheidungen trotzdem nötig werden – und dann keine klare Handlungsanweisung existiert.

Robotaxis weltweit: Wer testet, wer zögert, wer bremst?

In Europa sind über 1.400 autonome Fahrzeuge in Pilotbetrieb. Die meisten operieren auf Level 3 (teilautomatisiert). Vollautonome Serienfahrzeuge (Level 4) sind laut Prognose der deutschen Automobilindustrie ab 2027 denkbar, aber nur unter strengen Auflagen und zunächst in spezifischen Einsatzbereichen wie dem Shuttle-Verkehr oder Autobahnpiloten.

In den USA ist man weiter: Waymo und Cruise betreiben Robotaxis in San Francisco und Phoenix – ohne Sicherheitsfahrer. Ihre Systeme analysieren u.a. Personen, Schilder, Ampeln, Fahrbahnmarkierungen und andere Fahrzeuge. Grundlage ist eine Kombination aus Lidar, Radar und hochauflösenden Kameras, die ein 360-Grad-Bild der Umgebung erzeugen. Ein neuronales Netzwerk interpretiert diese Daten in Echtzeit, erkennt Bewegungsmuster und kann daraus Vorhersagen ableiten: etwa, ob ein Kind zur Straße läuft oder ein Auto abbiegen wird. So entsteht eine kontinuierlich aktualisierte Entscheidungsgrundlage – ganz ohne menschlichen Blick.

Autonome Systeme treffen im Minutentakt sicherheitsrelevante Entscheidungen. Und jede davon könnte zur moralischen werden.

Mensch vs. Maschine – wer fährt uns sicherer in die Zukunft?

Laut Daten der US-Verkehrsbehörde NHTSA liegt die durchschnittliche Unfallrate bei menschlichen Fahrer:innen bei etwa 1,52 Unfällen pro einer Million gefahrenen Meilen.

Im Vergleich dazu meldete Waymo im Jahr 2023 eine Unfallrate von 0,41 Unfällen pro Million Meilen, bei denen keine schwerwiegenden Personenschäden auftraten. Cruise verzeichnete im gleichen Zeitraum rund 1 Unfall pro Million Meilen, allerdings mit einzelnen Fällen von Personenschaden. Cruise musste deshalb 2024 wegen mehrerer Unfälle den Dienst einstellen. Waymo meldete über 80 kritische Zwischenfälle im selben Jahr.

Diese Zahlen deuten insgesamt darauf hin, dass autonome Systeme zumindest unter kontrollierten Bedingungen sicherer sein könnten als menschliche Fahrer:innen. Doch: Kritiker:innen warnen, dass KI-Systeme besonders bei seltenen, unvorhersehbaren Ereignissen – also genau jenen Situationen, die das Trolley-Problem beschreibt – noch immer deutliche Schwächen zeigen.

Warnung aus der Zukunft, gesprochen in der Vergangenheit

Norbert Wiener, der Begründer der Kybernetik, formulierte bereits in den 1950er-Jahren eine Warnung, die heute aktueller ist denn je:

„Der Einsatz von Maschinen, die selbst Entscheidungen treffen, ist ein moralisches Experiment, dessen Folgen wir erst beginnen zu verstehen.“

Wiener war einer der ersten, die erkannten, dass automatisierte Systeme nicht nur technische, sondern tiefgreifend gesellschaftliche Konsequenzen haben. Sein Werk bildet die Grundlage für heutige Diskussionen über autonome Entscheidungsprozesse – lange bevor das erste KI-gesteuerte Auto gebaut wurde.

Ausblick: Wem vertrauen wir das Lenkrad unserer Moral an?

Technisch sind autonome Entscheidungen längst möglich. Doch rechtlich und ethisch betreten wir ein hochsensibles Terrain, auf dem jede programmierte Reaktion zur Grundsatzfrage wird.

Das Trolley-Problem ist längst kein akademisches Gedankenspiel mehr – es rollt mitten durch unsere Städte.

Quellen:

Wiener, Norbert. The Human Use of Human Beings: Cybernetics and Society. Boston: Houghton Mifflin, 1954.

Zero Congestion with Self-driving Vehicles | General Motors

Self-Driving Car Technology for a Reliable Ride - Waymo Driver

GM's Cruise robotaxi service faces fine in alleged cover-up of San Francisco accident's severity

Points of reference: Robotaxi safety

Tesla Fahrzeugsicherheitsbericht | Tesla Österreich

EU auditors warn that road safety goals will not be achieved unless efforts are moved up a gear