Kreativität ohne Kreator: Wenn der Prompt der neue Komponist ist

Was haben ein melancholisches Klavierstück, ein viraler TikTok-Beat, ein KI-generiertes Musikvideo und ein fotografischer Traum gemeinsam? Sie könnten alle ohne menschliche Hand komponiert, gefilmt oder geschossen worden sein – und trotzdem berühren. Willkommen in der Ära der generativen Kreativität, in der auch eine KI der Rockstar von morgen sein kann.

Wenn Kreativität aus Rauschen entsteht – ein Deep Dive in Diffusionsmodelle

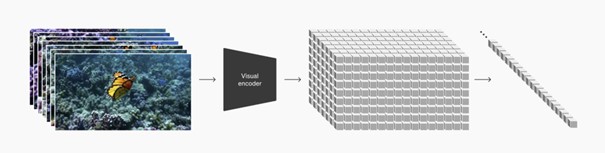

Wie schafft es KI, aus einer Texteingabe ein realistisches Bild, ein Musikstück mit Takt und Gefühl oder ein ganzes Video zu erzeugen? Die Antwort liegt in einem Verfahren namens Diffusionsmodell – das heute als Standard für die leistungsstärksten generativen Modelle gilt, etwa bei Stable Diffusion, SORA oder DALL·E 3.

🌀 Phase 1: Die Vorwärtsdiffusion – Struktur wird zu Rauschen

Zuerst wird ein reales Beispiel – etwa ein Bild oder Audiofile – über hundert bis tausend Schritte hinweg systematisch mit Rauschen (z. B. Gaußsches Rauschen) überlagert. Dieser sogenannte Noising-Prozess zerstört gezielt die ursprüngliche Struktur, bis nur noch Zufall übrig bleibt - das Bild enthält keine erkennbaren Muster mehr. Die KI lernt so, wie Struktur in Daten verloren geht – was essenziell ist, um sie später wiederherstellen zu können.

↩️ Phase 2: Rückwärts durch das Rauschen – wie aus Chaos Struktur wird

Der eigentliche Zauber generativer KI beginnt dort, wo für uns normalerweise Schluss ist: bei komplettem Rauschen. Nachdem das ursprüngliche Ausgangsmaterial im ersten Schritt systematisch verrauscht wurde, dreht das Modell nun den Prozess um – Schritt für Schritt zurück in Richtung Klarheit. Diese Phase heißt Reverse Diffusion.

Dabei schätzt ein neuronales Netz (häufig ein modifiziertes U-Net) bei jedem Schritt, was Rauschen ist – und was bereits Teil des finalen Outputs. Die KI lernt sozusagen, das Rauschen gezielt zu entfernen, bis das eigentliche „Werk“ sichtbar wird. Und genau darin liegt ihre kreative Logik: nicht Erschaffen im klassischen Sinn, sondern algorithmisches Entdecken möglicher Welten im Rauschen.

Gelenkt wird dieser Rückführungsprozess durch sogenannte Guidance-Signale. Und hier kommt der Mensch (indirekt) wieder ins Spiel:

Ein Textprompt wie „a cat in a spacesuit“ oder „slow piano ballad, 90 BPM, emotional tone“ wird zunächst über ein Sprachmodell wie CLIP, T5 oder Whisper in eine semantische Repräsentation übersetzt. Dieses Vektormodell enthält eine verdichtete Bedeutung des Textes – und wird bei jedem Schritt der Rauschreduktion einbezogen.

Die Technik dahinter nennt sich Classifier-Free Guidance oder Cross-Attention: Das Modell vergleicht laufend das gerade generierte Zwischenergebnis mit dem Bedeutungssignal des Prompts – und passt seine Richtung an. Ist das hier noch „Raumanzug-Katze“? Klingt das schon „melancholisch und getragen“? So entstehen Werke, die nicht nur technisch präzise, sondern auch inhaltlich stimmig wirken – ganz ohne direktes menschliches Eingreifen.

Am Ende dieses Prozesses steht ein vollständiges Bild, ein Song oder ein Videoframe – rekonstruiert aus statistischem Rauschen, gelenkt durch Wahrscheinlichkeiten, gelerntes Wissen und semantische Zielvorgaben. Es sieht nicht so aus, als hätte es eine KI gemacht. Es sieht aus, als wäre es schon immer da gewesen.

Zusammengefasst: Prompt eingeben, klicken, hören – und plötzlich läuft ein Song, den kein Mensch je geschrieben hat, aber der trotzdem klingt, als könnte er in den Charts landen.

Die KI weiß dabei nichts über Musik, Farben oder Kamerabewegung. Sie hat lediglich Milliarden von Muster gelernt – mathematische Beziehungen, Wahrscheinlichkeiten und Übergänge.

Beispiel 1: Theorie im Bild - wie KI Fotografie neu definiert

Fast jede:r hat es schon erlebt: Du machst ein Foto bei Dämmerung – und das Bild sieht besser aus als die Szene selbst. Möglich macht das der KI-gestützte Nachtmodus moderner Smartphones. Dabei handelt es sich nicht um klassische Fotografie, sondern um eine datengetriebene Rekonstruktion dessen, was hätte sichtbar sein können. Und das funktioniert so:

- Das Smartphone nimmt nicht ein Bild auf, sondern mehrere Einzelbilder mit unterschiedlichen Belichtungen und Verschlusszeiten - innerhalb von Millisekunden

- Eine speziell trainierte KI analysiert diese Daten: Was ist Rauschen? Was ist Bewegung? Wo ist Detail?

- Das Bild wird nicht „geschärft“, sondern durch einen multimodalen Fusionsprozess (vergleichbar mit Diffusionsmodellen) neu zusammengesetzt – Pixel für Pixel, basierend auf Wahrscheinlichkeiten.

Das Bild ist also kein „Foto“ im klassischen Sinn – sondern eine statistische Rekonstruktion dessen, was du hättest sehen können, wenn dein Auge präziser wäre. Ergebnis: Der Mond ist klar, Gesichter leuchten – Realität 2.0.

Doch das ist erst der Anfang. Schon jetzt oder in naher Zukunft erwartet uns auf dem Smartphone:

- Scene Expansion (→ ähnlich wie Generative Fill bei Photoshop): Die KI erweitert den Bildausschnitt jenseits der physischen Linse – z. B. ein Bergpanorama, das in Wirklichkeit nie vollständig im Frame war.

- AI Relighting: Du kannst nachträglich die Lichtquelle verschieben oder die Tageszeit simulieren – auf Basis einer 3D-Tiefenabschätzung, die dein Handy im Hintergrund erstellt.

- Detailvervollständigung: Aus einem verschwommenen Schatten wird eine scharf konturierte Gestalt – obwohl diese im Original nie sichtbar war.

Beispiel 2: From Prompt to Platinum – die Rockstar-Logik der Musik-KI

Auch in der Musikbranche sind die ersten KI-Modelle längst dabei, sich eine Fanbase und Musikkarriere aufzubauen. KI-Modelle wie Suno und Udio liefern längst keine musikalischen Skizzen mehr, sondern vollwertige Produktionen. Aus einem einzigen Textprompt entsteht ein kompletter Song: mit Gesang, Harmonie, Arrangement und stilistischer Tiefe. Jeder Takt wird in Echtzeit berechnet, jede Note durch semantische Vektoren gelenkt, jeder Klangschritt aus reinem Rauschen modelliert.

Was früher mehrere Tage, Studios, Mikrofone und ganze Teams brauchte, erledigt heute teilweise ein Algorithmus – Frame für Frame, Note für Note. Und das Resultat? Tracks mit natürlicher Intonation, rhythmischer Präzision und genretypischem Sound – synthetisch berechnet, aber klanglich kaum noch von realen Studioaufnahmen zu unterscheiden.

Eine aktuelle Studie, veröffentlicht am 16. April 2025 von Digital Music News, zeigt eindrucksvoll, wie schwer es selbst geschulten Hörer:innen fällt, KI-generierte Musik von menschlich komponierten Stücken zu unterscheiden. In mehreren Doppelblindtests, bei denen sowohl Laien als auch professionelle Musiker:innen teilnahmen, konnte die Mehrheit (55%) der Befragten die Herkunft der Songs nicht korrekt zuordnen. Erstaunlich: Viele der KI-komponierten Werke wurden sogar als besonders emotional oder innovativ bewertet.

Beispiel 3: Kamera läuft nicht – aber die KI schon: AI-generierte Videos mit SORA & Co

OpenAIs Modell SORA hebt Text-to-Video auf ein neues Level: Aus einem Prompt wie „ein Hund rennt über eine verschneite Wiese bei Sonnenuntergang“ entsteht ein realistisches, bewegtes Video mit Tiefe, korrekter Lichtführung und physikalischer Logik. Möglich machen das:

- Diffusionstechniken für konsistente Bildabfolgen und flüssige Übergänge

- Gelerntes physikalisches Verhalten (z. B. wie Schnee fällt, wie sich Muskeln bewegen)

- Probabilistische Weltmodelle, die typische Szenenstrukturen erschließen

Was du siehst, wurde nie gefilmt –fühlt sich aber genauso an.

Die Zukunft hört sich gut an – nur wissen wir bald nicht mehr, wer sie singt.

Fazit: Zukunftsmusik mit Zwischenmenschlichkeit

KI komponiert Songs, optimiert Nachtfotos, generiert Videos, simuliert Licht und ergänzt Texte. Sie arrangiert Musik, erweitert Bildausschnitte, erkennt Inhalte – und macht auch juristische Themen zugänglich. Sie ist nicht nur Werkzeug, sondern aktiver Teil kreativer Prozesse.

Gerade deshalb lohnt es sich, heute die richtigen Leitplanken zu setzen – und eine Vision für human-centered AI: Ob in der Fotografie, Musik oder im juristischen Bereich, etwa mit Tools wie der Genjus KI, liegt der wahre Schatz aktuell nicht im Ersetzen, sondern im Stärken und Ermöglichen. In der Unterstützung von Menschen, die mit Leidenschaft gestalten, entscheiden und denken – und KI als kreative Sidekicks, Co-Pilotin und Sparringpartnerin begreifen – als Verstärkerin menschlicher Vision.

Nicht die KI macht den Unterschied – sondern, wie wir sie nutzen.

Quellen:

https://www.digitalmusicnews.com/2025/04/16/humans-struggle-to-accurately-identify-ai-music-study