Digitale Täuschung im Wahljahr: Deepfakes, TikTok-Wars und die Macht der Algorithmen

Täuschend echt – was sind Deepfakes überhaupt?

Ein Kanzlerrücktritt im Video. Ein panischer Anruf mit vertrauter Stimme. Beide erschreckend glaubwürdig – beide komplett gefälscht. Willkommen in der Welt der Deepfakes.

Deepfakes greifen unsere fundamentalen Orientierungsmechanismen an: Was ist echt? Was kann ich glauben? Deepfakes unterwandern unsere Fähigkeit, zwischen Wahrheit und Fiktion zu unterscheiden – mit direkten Auswirkungen auf Vertrauen, gesellschaftlichen Diskurs und demokratische Prozesse. Sie sind nicht bloß digitale Spielerei, sondern ein Instrument strategischer Manipulation – subtil, skalierbar und zunehmend schwer zu entlarven.

Wie Deepfakes entstehen – Technologie, die täuscht

Deepfakes sind manipulierte oder synthetisch erzeugte Medieninhalte – meist Videos oder Audios –, die mithilfe künstlicher Intelligenz erstellt werden.

Die Technologie basiert meist auf sogenannten Generative Adversarial Networks (GANs) oder neueren multimodalen Modellen wie GPT-4o, Sora oder RunwayML. Vereinfacht gesagt:

Ein Modell wird mit vielen Bild-, Audio- oder Videodaten trainiert (z. B. stundenlange Reden eines Politikers). Es lernt Muster, Stimme, Gesichtsausdruck, Sprechtempo. Daraus generiert es neue Inhalte – perfekt imitiert. Für Stimmklone genügen heute 60 Sekunden Audio – z. B. über Tools wie ElevenLabs.

Was dabei entsteht, ist kein simples Fake – es ist ein digitaler Doppelgänger. Ein Mensch, der Dinge tut oder sagt, die er im realen Leben nie getan oder gesagt hat.

Skandale, die die Welt aufhorchen ließen: Der Biden-Robocall 2024

Im Januar 2024 erhielten tausende Wähler:innen in New Hampshire einen Anruf – angeblich vom Präsidenten persönlich. Inhalt: „Geht nicht zur Vorwahl, spart euch den Weg.“ Die Stimme klang exakt wie Biden. Es war ein Stimm-Deepfake (hier anhören)

Impact:

- Die Wahlbeteiligung sank spürbar in betroffenen Regionen.

- Die US-Regierung sprach von „Wählersuppressions-KI“.

- Der Urheber wurde später identifiziert und angeklagt – es drohen mehrere Jahre Haft.

- Die FCC verhängte eine Rekordstrafe von 6 Millionen US-Dollar.

Ein Zitat aus dem Guardian machte die Runde: „Wir müssen uns daran gewöhnen, dass nicht alles, was wir hören, real ist – selbst wenn es klingt wie der Präsident.“

Deepfakes im Alltag: Die „Enkeltrick“-Version 2.0

Mit der zunehmenden Verbreitung von KI nimmt auch die Raffinesse krimineller Maschen zu. In der ORF-Sendung „Akte Betrug“ vom 24. April 2025 wurde eine neue Welle von Deepfake-Betrugsfällen dokumentiert.

In der gleichen Sendung wurde zudem live ein Deepfake von Moderator Martin Ferdiny erstellt, in dem er Tom Cruise zum Verwechseln ähnlich sah – ein eindrucksvoller Beweis dafür, wie einfach heute Identitäten gefälscht werden können.

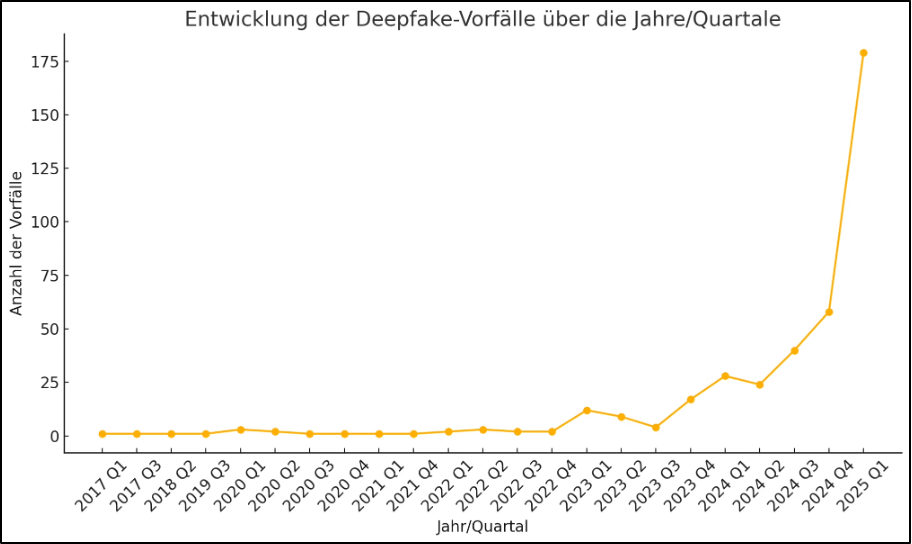

Insgesamt gingen in Österreich bereits mehrere Millionen Euro durch KI-gestützte Betrugsmaschen verloren. Polizeibehörden berichten von einer Verdreifachung entsprechender Anzeigen im Vergleich zu 2022.

Doch Deepfakes bleiben nicht auf private Betrugsfälle beschränkt. Auch in der politischen Kommunikation entfalten sie ihre Wirkung – besonders dort, wo junge Menschen ihre Informationen beziehen: auf Plattformen wie TikTok.

TikTok-Wars: Der Wahlkampf als Meme-Schlacht

Auch TikTok ist längst nicht nur mehr ein Ort für Tanzvideos – sondern ein strategisches Spielfeld für Parteien, Trolle und Desinformationskampagnen. Kaum eine Plattform prägt junge Wähler:innen so stark wie TikTok. Und der Algorithmus? Der liebt Extreme mit Polarisierungspotenzial.

Mit Blick auf die vergangenen Wahlen in Deutschland und die aktuelle Entwicklung in der österreichischen Politik stellt sich die Frage: Wie genau zeigt sich diese Dynamik im politischen Alltag auf TikTok?

- Reichweite & Strategie: AfD und FPÖ erzielen auf TikTok teils doppelt so viele Interaktionen wie andere Parteien. 68 % der viralen politischen Videos 2024 waren AfD-nah (Universität Wien). Die AfD steigerte ihre Reichweite in nur sechs Monaten um 146 %.

- Verzerrte Wahrnehmung: Selbst wer nach SPD oder Grünen sucht, bekommt laut Studien oft zuerst AfD-Inhalte vorgeschlagen.

- DE Bundestagswahl 2025: Verschiebung bei Erstwähler:innen: Die jungen Wähler:innen wählen unerwartet: Die Linke und die AfD teilen sich die die Top-Platzierungen. Fast jede:r zweite Erstwähler:in hat ihre, bzw. seine Stimme einer der zwei politischen Randparteien im Bundestag gegeben. Dieses Wahlergebnis spiegelt TikTok. Laut dem Forschungsprojekt Sparta der Universität der Bundeswehr in München entfielen zur Bundestagswahl 2025 fast die Hälfte aller TikTok-Videoaufrufe auf die AfD und die Linke.

TikTok als Trendbarometer: Laut BR und dem Forschungsprojekt Sparta gewinnen die politischen Ränder online – nicht durch Programme, sondern durch Algorithmus-Kompatibilität: klare Botschaften, starke Emotionen, einfache Erzählmuster. Gefälschte Interviews, manipulierte Zitate, aus dem Kontext gerissene Szenen – all das geht viral.

- TikTok erzeugt Filterblasen, die Fakten verzerren und Emotionen über Information stellen. Das führt dazu, dass sich politisch Unentschlossene schnell in einem narrativen Tunnel wiederfinden – und möglicherweise ihre Wahlentscheidung auf Basis eines Deepfakes treffen.

X, Elon Musk und der Rückbau der Moderation

Auch auf der Plattform X wurde die Moderation weiter zurückgefahren – mit drastischen Folgen: Laut EU-Verhaltenskodex war X Ende 2024 die Plattform mit den meisten Verstößen gegen Desinformationsregeln im Zusammenhang mit Wahlen.

Ein Bericht aus Brüssel bezeichnet X inzwischen als „Katalysator für polarisierende Deepfakes“ – und warnt vor einem strukturellen Governance-Problem: fehlende Kontrolle, intransparente Algorithmen und ein Geschäftsmodell, das Polarisierung begünstigt.

Was hilft gegen die perfekte Lüge? – Abwehrmechanismen & rechtliche Maßnahmen

Technische Gegenmittel

- Deepfake-Erkennungstools (Meta, Google): Noch fehleranfällig – besonders bei Audio.

- Digitale Wasserzeichen: Im EU AI Act verpflichtend für Hochrisiko-KI.

- Labels für KI-generierte Inhalte: TikTok, YouTube & Co. testen sie – sie sind aber oft schlecht sichtbar oder leicht zu umgehen.

Rechtliche Pflichten

- EU AI Act: Verpflichtet zu Transparenz und Labeling für synthetische Medien.

- DSA (Digital Services Act): Plattformen müssen aktiv gegen Desinformation vorgehen – inkl. Löschung, Risikoberichten und Algorithmen-Checks.

- In den USA: Erste Bundesstaaten wie Kalifornien verbieten Deepfake-Desinformation in Wahlkämpfen, sofern nicht klar als Satire gekennzeichnet.

Fazit: Wer heute wählt und vertraut, muss doppelt hinsehen

Deepfakes verändern nicht nur unseren Medienkonsum, sondern die Spielregeln der Demokratie. Sie machen aus Wahrheit eine Frage des Timings, der Klickzahlen, der Codezeile. Was hilft? Medienkompetenz, technische Wachsamkeit, politischer Wille – und ein Recht, das mithält. „Die größte Gefahr ist nicht die Technik – sondern unser Vertrauen in das, was wir sehen wollen. “

Deshalb: Don’t believe everything you see – even if you see it. – sinngemäß zitiert nach dem US-Cybersicherheitsbericht 2024.

5 Anzeichen für potenzielle Deepfakes:

- Unnatürliche Details bei Stimme oder Mimik

Wirken Gestik, Lippensynchronisation oder Tonfall minimal „off“? Dann besser zweimal hinschauen. - Übertriebene Emotionen

Inhalte, die Wut, Angst oder Euphorie gezielt triggern, dienen oft der Manipulation – und sind besonders anfällig für Fakes. - Keine unabhängige Bestätigung

Keine seriöse Quelle bestätigt den Inhalt? Vorsicht – womöglich ist es ein gezielter Täuschungsversuch. - Verdächtige Upload-Metadaten

Wer hat das Video veröffentlicht? Wann? Aus welchem Kontext stammt es? Ein kurzer Check gibt oft Aufschluss. - Rückwärtssuche von Bild oder Audio

Tools wie Reverse Image Search oder Deepfake-Detektoren helfen, verbreitete Fälschungen zu enttarnen.

Bildquelle: Deepfake-Vorfälle 2025: Wie man KI-Fälschungen erkennt und sich schützt

Quellen:

Fake Biden robocall tells voters to skip New Hampshire primary election

„Akte Betrug“ am 24. April über Deepfakes – Wenn Promis als Lockvögel missbraucht werden, Cybertrading und Enkeltrick

TikTok-Wahlkampf: Die politischen Ränder gewinnen die Jugend | BR24